论文:Private, Efficient, and Accurate: Protecting Models Trained by Multi-party Learning with Differential Privacy.

会议:IEEES&P 2023

作者:Wenqiang Ruan, Mingxin Xu, Wenjing Fang, Li Wang, Lei Wang, Weili Han

简介:安全多方学习(基于安全多方计算的机器学习)已成为解决隐私保护数据流通问题的一项重要技术。尽管底层的安全多方计算协议为计算过程提供了严格的安全性保障,经由安全多方学习训练得到的模型依然无法抵抗那些仅依赖模型访问的攻击手段,例如成员推理攻击。另一方面,尽管差分隐私技术能够帮助抵御成员推理攻击,其所要求的大量随机噪声会给模型带来较大的精度损失。同时,底层的安全多方计算协议会为学习过程带来大量的通信开销。因此,如何在安全多方学习过程中平衡隐私保障、效率以及精度是一个亟待解决的问题。

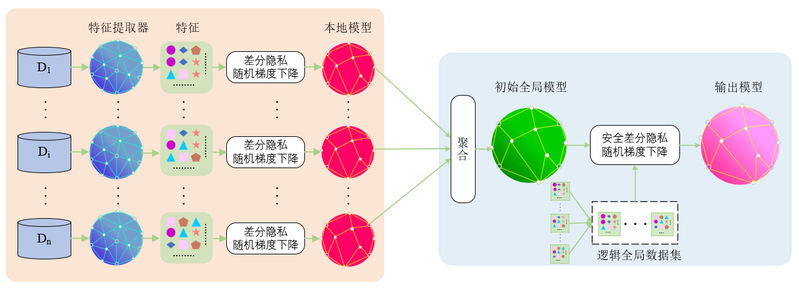

我们通过提出一个安全差分隐私随机梯度下降协议以及两种对效率与精度的优化方法解决上述问题。首先,我们提出一个安全差分隐私随机梯度下降协议以在基于秘密共享的安全多方学习框架中实现差分隐私随机梯度下降算法。随后,为了降低差分隐私带来的精度损失并提升安全多方学习的效率,我们从安全多方学习训练过程的角度提出了两种优化方法:(1)用于简化模型结构的数据无关特征提取方法;(2)基于本地数据的全局模型初始化方法,用于加速模型训练过程的收敛。随后,我们在两个开源安全多方学习框架(TF-Encrypted和Queqiao)上实现了上述协议与优化方法。在多个数据集上的实验结果验证了上述协议与方法的效率与有效性。例如,在局域网环境下,当![]() 时,我们可以在7分钟内基于CIFAR-10数据集训练一个精度达到88%的分类模型。上述结果远远优于当前最新的安全多方学习框架CryptGPU(其需要花费超过16个小时基于CIFAR-10数据集训练一个精度达到88%的无差分隐私保护的神经网络模型)。

时,我们可以在7分钟内基于CIFAR-10数据集训练一个精度达到88%的分类模型。上述结果远远优于当前最新的安全多方学习框架CryptGPU(其需要花费超过16个小时基于CIFAR-10数据集训练一个精度达到88%的无差分隐私保护的神经网络模型)。

上述工作主要基于FudanMPL开源平台完成。FudanMPL是国内第一个开源的安全多方学习平台,由复旦大学数据分析与安全实验室开发并维护,目前共包含四个子项目,支持多方场景下的横向学习、纵向学习、模型训练、模型预测等多个场景。目前,数据分析与安全实验室仍在持续开发维护FudanMPL平台,努力使其成为一个可用于解决实际数据流通问题的的多场景安全多方学习平台。